这些神经网络基于海量数据训练, 可为推动生成式 AI 革命的应用提供支持。

这些神经网络基于海量数据训练, 可为推动生成式 AI 革命的应用提供支持。

+++

编者注:本文属于《解码 AI》系列栏目, 该系列的目的是让技术更加简单易懂, 从而解密 AI, 同时向 RTX PC 用户展示全新硬件、软件、工具和加速特性。

万丈高楼平地起, 一砖一瓦皆根基。由 AI 驱动的应用也是如此。

基础模型是利用海量原始数据训练而成的 AI 神经网络, 其训练以无监督式学习为主。

这种人工智能模型经过专门训练, 可以理解并生成人类语言。想象一下, 将一台计算机放在偌大的图书馆里, 并准备大量的书籍供它阅读和学习, 随后它就能像人类一样理解上下文, 以及词句背后的含义了。

因其具备强大的知识库和使用自然语言进行交流的能力, 基础模型的应用范围非常广泛, 包括生成和总结文本、辅助生成和分析计算机代码、创作图像和视频, 以及进行音频转录和语音合成。

ChatGPT, 作为尽人皆知的生成式 AI 的典型代表, 就是基于 GPT 基础模型构建的聊天机器人该模型目前已推出第四版, 即 GPT-4。已经是既能接收文本或图像, 也能生成文本或图像回应的大型多模态模型了。

通常情况下, 基于基础模型构建的在线应用需要通过数据中心来访问这些模型。但现在, 许多此类模型及其驱动的应用都能在配备 NVIDIA GeForce 和 NVIDIA RTX GPU 的 PC 和工作站上本地运行。

基础模型的用途

基础模型具有各种各样的功能, 包括:

● 语言处理:理解和生成文本

● 代码生成:对计算机代码进行分析和调试 (支持多种编程语言)

● 视觉处理:分析和生成图像

● 语音:根据文本生成语音, 以及将语音转录为文本

用户可以进一步优化基础模型或直接将其投入使用。为每个生成式 AI 应用训练全新的 AI 模型是相当耗资费时的, 所以用户往往会通过对基础模型进行微调来满足特定的应用场景。

得益于提示词和检索增强生成 (RAG) 等数据检索技术, 经过预训练的基础模型可展现出出众性能。此外, 基础模型也很擅长迁移学习, 这代表用户可以训练模型执行与其初始用途相关的第二个任务。

例如, 如果一款通用大型语言模型 (LLM) 的功能是与人类对话, 那在经过进一步训练后, 该模型就能被用作客服聊天机器人, 利用企业知识库来为客户答疑解惑。

如今, 各行各业的公司都会对基础模型进行微调, 以便将各自 AI 应用的性能发挥到极致。

基础模型的种类

目前, 投入使用的基础模型已超过 100 种, 而这个数字还将持续增长。LLM 和图像生成器是非常热门的两类基础模型。任何人都可以通过 NVIDIA API 目录免费试用多种此类模型, 且这种试用对硬件没有要求。

LLM 模型能够理解自然语言并对问题做出回应。例如,Google 的 Gemma 就很擅长文本理解和转换, 以及代码生成。如果问它关于天文学家 Cornelius Gemma 的问题, 它会回答:「他在天文导航和天文学方面的贡献为科学进步带来了重大影响。」同时, 它还会提供 Cornelius Gemma 的主要成就、宝贵遗产等方面的信息。

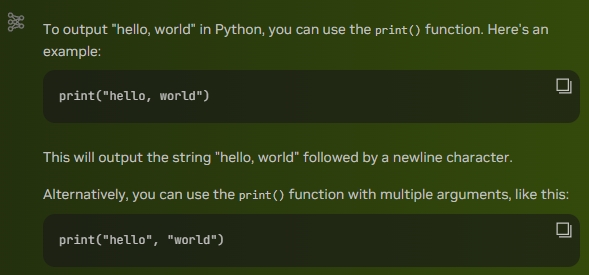

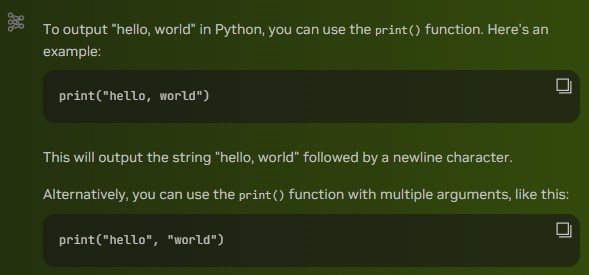

Google 的 CodeGemma 由 RTX GPU 上的 NVIDIA TensorRT-LLM 加速, 可为开发者社区带来强大的轻量化编码功能, 进一步扩展了 NVIDIA 和 Google 在 Gemma 模型方面的协作。CodeGemma 提供了 7B 和 2B 两种预训练模型, 专用于代码补全和代码生成任务。

MistralAI 的 Mistral LLM 能够遵循用户指令, 完成各种请求和生成创意文本。事实上, 在撰写这篇文章的标题时, 我们请 Mistral 使用「AI 解码」的近义词, 然后它就给出了现在的标题, 并进一步编写了基础模型的定义.

名副其实的 Hello, world

Meta 的 Llama 2 是一款先进的 LLM, 可以根据提示词生成文本和代码。

用户可通过 NVIDIA ChatRTX 技术演示应用, 在 RTX PC 和工作站上体验 Mistral 和 Llama 2。ChatRTX 允许用户通过 RAG 将基础模型与其个人资料 (例如文档、医生笔记及其他数据) 关联, 实现模型的个人化。ChatRTX 由 TensorRT-LLM 加速, 可迅速提供与上下文相关的回答。此外,ChatRTX 在本地运行, 既保证数据安全, 又实现快速响应。

用户可通过 StabilityAI 的 Stable Diffusion XL 和 SDXL Turbo 等图像生成器生成各种图像和令人惊艳的逼真视觉效果。StabilityAI 的视频生成器 Stable Video Diffusion 会以单个图像为条件帧, 并利用生成式扩散模型基于条件帧生成多个帧, 再将其合成为视频序列。

多模态基础模型能够同时处理多类数据 (例如文本和图像), 生成更为复杂的输出。

如果一款多模态模型同时支持文本和图像, 那么用户就可以上传图像并询问与该图像相关的问题。这类模型正在快速融入客服等实际应用领域, 相比于传统手册, 它们能够更快作出回应, 也更便于用户使用。

Kosmos 2 是 Microsoft 的开创性多模态模型, 旨在按照人类的模式理解和处理图像中的视觉元素。

思考时放眼全球, 运行 AI 模型时立足「本地」

GeForce RTX 和 NVIDIA RTX GPU 能够在本地运行基础模型。

既保证数据安全, 又实现快速响应。这是因为用户无需依靠基于云的服务, 只需利用 ChatRTX 等应用就能在本地 PC 上处理敏感数据, 不必连接互联网或与第三方共享数据。

用户可以列表中选择开放的基础模型并下载, 然后在自己的硬件上运行。与使用基于云的应用和 API 相比, 这种方式不仅成本更低, 还能解决延迟和网络连接方面的问题。

###

来源:互联网