10 月 16 日消息,顶级学术会议 SOSP 2025 在韩国首尔举行。

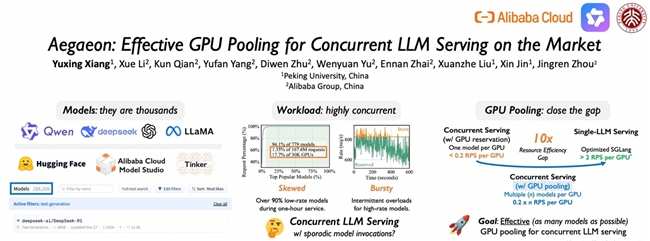

10 月 16 日消息,顶级学术会议 SOSP 2025 在韩国首尔举行,本届会议仅收录 66 篇论文,其中阿里云提出的 GPU 池化服务多模型研究成果成功入选,该研究提出多模型混合服务系统 Aegaeon,可大幅提升 GPU 资源利用率,目前其核心技术已应用在阿里云百炼平台。

SOSP(操作系统原理研讨会)由 ACM SIGOPS 主办,是计算机系统领域顶级学术会议,平均每年收录的论文数量仅有数十篇,被誉为计算机操作系统界的「奥斯卡」,入选论文代表了操作系统和软件领域最具代表的研究成果。本届 SOSP 大会,关于系统软件与 AI 大模型技术的融合研究成为新的趋势。

全球模型的数量仍在持续增长,据统计,Hugging Face 已托管了超 100 万个模型。在真实服务场景中,少量热门模型占据了总请求的绝大部分,而超过 90% 的模型则调用频率较低。当前的事实标准解决方案是为每个模型至少预留一个推理实例,这造成了 GPU 资源的大量浪费。

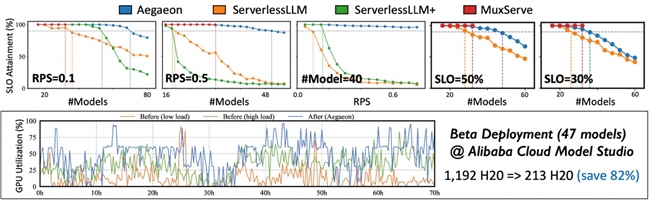

阿里云百炼团队在论文中创新性提出多模型混合服务系统 Aegaeon,首次将调度实现在 token 级别,在每次生成完下一个 token 之后,都可通过精确的执行时间预测和创新的 token 级调度算法规划是否需要切换模型,从而实现多个模型混合服务且满足延迟要求;通过组件复用、显存精细化管理和 KV 缓存同步优化等全栈技术,Aegaeon 将模型切换开销降低 97%,确保了 token 级调度的实时性,可支持亚秒级的模型切换响应。据介绍,Aegaeon 系统支持单 GPU 同时服务多达 7 个不同模型,相比现有主流方案提升 1.5-9 倍的有效吞吐量,实现 2-2.5 倍的请求处理能力。

Aegaeon 显著提升 GPU 利用率

目前,Aegaeon 核心技术已在阿里云百炼平台部署,服务数十个模型的推理,将服务这些模型所需的 GPU 数量减少了 82%。

据介绍,阿里云百炼平台已上线 Qwen、Wan、DeepSeek 等 200 多款业界领先的模型,过去一年,阿里云百炼平台的模型调用量增长了 15 倍。

来源:互联网