在算力需求爆炸式增长的今天,CPU 与加速器之间的互联瓶颈已成为制约性能的关键因素。

在算力需求爆炸式增长的今天,CPU 与加速器之间的互联瓶颈已成为制约性能的关键因素。CXL(Compute Express Link) 凭借其高带宽、低延迟和内存一致性的优势, 正被业界视为下一代异构计算的「通用语言」——它不仅能无缝兼容 PCIe 生态, 更通过硬件级内存池化、资源共享等能力, 彻底打破「内存墙」与「IO 墙」的桎梏。

从英特尔、AMD 等芯片巨头的全力押注, 到阿里云、浪潮等云计算和服务器厂商的场景化部署,CXL 生态已呈现「诸侯林立」之势, 需要多久能完成从「技术领先」到「江湖一统」的跨越?

一、 产业生态:国内外大厂的布局与产品进展

阿里云 PolarDB:基于 CXL 的性能突破

阿里云在 CXL 技术的商业化应用方面处于领先地位。2025 年 2 月, 阿里云表示, 即将于下半年发布全球首款基于 CXL 交换机的数据库专用服务器。利用 CXL 高速互联技术, 进一步提升三层分离架构下计算与内存之间的通信带宽与效率。与传统的 RDMA 高速网络相比,CXL 技术将性能提升了一个数量级, 跨机交互延迟缩短至百纳秒级别。并且在相同配置下,PolarDB 的扩展性提升了三倍, 整体成本降低了 50%。

阿里云 PolarDB AI 版本深度集成大模型算子, 实现了在线推理吞吐量 10 倍的提升, 同时部署成本大幅下降。以配备单根 256GB 内存、连接 7 台物理机的 CXL Switch 内存池的 PolarDB 数据库为例, 一个机柜可以支持 16TB 的内存容量, 这时, 每台物理机都可以使用这 16TB 内存容量。这种内存池化技术不仅提升了数据库的扩展性, 还显著降低了跨机交互的延迟和传输开销, 有效解决性能瓶颈问题。

海光:国产 CPU 的 CXL 2.0 突破

作为国内 X86 架构处理器的代表厂商, 海光近年来在 CXL 领域取得了显著进展。2025 年 5 月其最新旗舰级 CPU——海光 C86-5G, 不仅在硬件规格上实现全面升级, 更首次支持 CXL 2.0 协议。该处理器拥有 128 个物理核心和 512 线程, 采用四路 SMT 技术 (每个核心可处理四个线程), 性能直追 Intel 和 AMD 的旗舰芯片。

此外,C86-5G 集成了 AVX-512 指令集, 并支持 16 通道 DDR5-5600 内存, 相比前代产品, 其内存带宽和容量均有显著提升。值得注意的是, 虽然 C86-5G 的 PCIe 5.0 通道数官方未明确披露, 但上一代 C86-4G 已拥有 128 条 PCIe 5.0 通道, 与 AMD 第四代 EPYC 7004 芯片相当。这一配置为加速器、NVMe 存储和高速网络提供了充足的带宽支持。更重要的是,C86-5G 对 CXL 2.0 的支持, 不仅使其在高性能计算环境中能够实现更高效的数据传输和资源利用, 还能在信创行业中继续跟上世界领先技术。

华为:积极布局, 从未缺席

华为持续积极参与 CXL 产业生态。其最新专利展示了一种具有高度可扩展性的处理器架构, 原生支持 CXL 技术。该架构具备更高带宽和更低延迟的特性, 能显著提升数据访问效率。简而言之,CXL 技术支持动态内存分配和优先级调度, 最大化资源利用率, 从而在实际应用中带来显著性能提升。

据专利描述, 数据处理的有效带宽可达 PCIe 的 4 倍, 而延迟则可降低至原先的 40% 以下。这将极大提升 CPU 与加速器的协作效率, 满足各类高性能应用的需求。

服务器及硬件厂商

浪潮: 在 CXL 生态中积极布局服务器硬件, 推动产品线向异构计算方向演进, 支持多加速器协同计算。2025 年, 浪潮已正式向市场推出元脑系列 CXL 服务器产品。

联想与新华三: 这两家厂商在 CXL 生态中也扮演着重要角色。联想在其服务器平台中集成 CXL 技术, 优化内存池化能力;新华三则在存储领域推出支持 CXL 内存池扩展的整机方案, 助力 AI 算力扩展。这两家产品在 2025 年都即将上市。

澜起科技: 已推出多款 CXL 相关产品, 包括全球首款符合 CXL 2.0 规范的 MXC(CXL 内存扩展控制器芯片) 芯片和 PCIe 5.0/CXL 2.0 Retimer 芯片。

江波龙: 推出的 CXL 2.0 内存拓展模块支持企业级应用, 通过 PCIe 4.0 接口实现内存扩展, 为 AI 训练和推理场景提供高带宽、低延迟的存储解决方案。

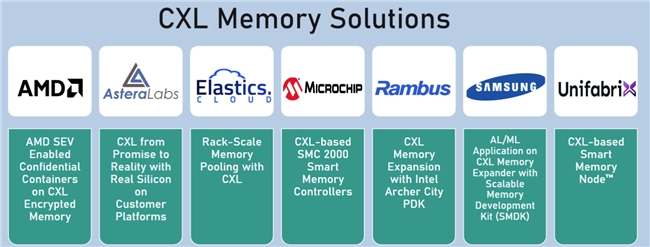

国际厂商的布局与生态构建

Intel: 其至强系列 Sapphire Rapids 处理器 (2025 年发布) 已支持 CXL 2.0 协议, 并计划于 2025 年底推出支持 CXL 3.1 的版本。新版本引入可信安全协议 (TSP), 支持基于虚拟化的可信执行环境 (TEE), 以处理机密计算工作负载。

AMD: Turin 处理器 (2024 年发布) 已支持 CXL 2.0 协议, 并计划在 2025 年底发布支持 CXL 3.1 的产品。其 FPGA 产品线率先支持了 CXL 2.0。

Marvell: 在 CXL Switch 和 Retimer 芯片上持续创新, 为多加速器互联提供关键硬件支持。目前已有样片可以获得。

Astera Labs: 早在 2024 年就推出了业界首个 CXL 2.0 Memory Accelerator SoC Platform。作为纳斯达克市场为数不多的 CXL 概念股,Astera Labs 的股价走势很好地反映了市场的预期。

三星与 SK Hynix: 作为全球领先的存储厂商, 已推出 CXL 兼容的 DRAM 产品。三星的 512GB CXL DRAM 内存模组采用澜起科技的 MXC 芯片, 支持 CXL 2.0 协议, 内存容量是传统产品的四倍, 系统延迟仅为五分之一。SK Hynix 则通过 CXL 内存扩展器, 为 AI 训练和推理提供高带宽、低延迟的存储解决方案。据悉, 两家即将推出自己的 CXL 控制器芯片。

二、 技术演进:CXL 与 GPU Memory

CPU 领域如何利用 CXL, 已有大量文章和案例阐述, 此处不再赘述。而在 GPU Memory 领域,CXL 的应用同样展现出巨大潜力。英伟达作为 CXL 联盟成员, 已前瞻性地探索利用 CXL 降低成本:

案例一:

NVIDIA L40S GPU 测试数据显示,2 个 L40S GPU 搭配 CXL 内存后, 内存需求从 2560GB 降至 1024GB,CPU 利用率从 65% 降至 25%, 瓶颈效应显著缓解。

案例二:

英伟达早已认识到 CXL 技术对 AI 推理场景的重要性。如今, 随着 DeepSeek 等大模型采用的算法 (如 Prefill/Decode 分离), 高频数据可置于 HBM, 而低频数据则可存放于 CXL 内存中, 从而显著降低硬件成本。

三、 CXL 与 UALink 协同支撑 AIDC 的 Scale Up

在 AI 驱动的数据中心 (AIDC) 中,Scale Up(垂直扩展) 是应对大模型训练和推理需求的关键。CXL 与 Ultra Accelerator Link (UALink) 通过互补的互联架构, 共同构建了高效能扩展网络。

CXL 的资源扩展和组网能力

CXL 通过共享内存池 (Memory Pool) 和缓存一致性协议, 实现 CPU 与加速器间的高效内存共享。例如,CXL 3.1 协议支持多主机访问同一内存池, 使得单台服务器的算力可扩展至数百个 GPU 节点。这种架构在训练大语言模型时, 可将训练效率提升至传统 PCIe 架构的 5 倍以上。同时,CXL 在机柜内的组网能力同样是未来数据中心解耦的关键所在。需特别指出,CXL 最大可支持 4096 个节点组网, 远超 NVLink。

UALink 的专一扩展设计

UALink 则专注于 GPU 节点之间的高速互联。其基于以太网的物理层设计, 结合高带宽、低延迟的 Switch 组网模式, 使多个加速器节点得以无缝连接。当前标准支持 1024 个节点组网, 规模同样超越 NVLink。

协同效应与行业应用

CXL 与 UALink 的结合形成了「双轮驱动」的扩展模式:在 AIDC 中,CXL 主要负责内存共享和 CPU 侧的组网, 而 UALink 则专注于 GPU 间的互联。这种协同架构不仅降低了硬件成本, 还通过统一的软件栈极大简化了资源调度。

四、 2026 年:CXL 技术的规模化拐点

2026 年被视为 CXL 技术发展的关键拐点。随着 CXL 2.0 产品日益成熟, 以及 3.1 和 3.2 规范的逐步完善, 其规模化应用将加速。据 Yole 预测, 到 2028 年, 支持 CXL 协议的数据中心服务器占比将达到 50%。全球 CXL 市场规模将突破 150 亿美元, 其中存储和内存扩展模块占比超 60%。

CXL 产业生态的快速发展

到 2026 年,CXL 产业生态将更加成熟。全球已有 250 多家厂商参与 CXL 联盟, 涵盖 Intel、AMD、Marvell、Samsung、SK Hynix、澜起科技、江波龙、华为、浪潮、联想、新华三、海光等。这些厂商在 CXL 芯片、Switch、内存扩展模块、存储设备等方面均有深度布局, 形成了完整的产业链。

CXL 产品层出不穷

2026 年,CXL 产品线将更加丰富多元。例如,Marvell 的 Structera 近内存加速器 (2024 年 7 月发布) 已支持 CXL 2.0, 为车载 AI 边缘计算提供了新思路。三星的 CXL 内存扩展器持续为 AI 训练和推理提供高带宽、低延迟的解决方案。此外,CXL Switch、Retimer 芯片、内存扩展卡、存储设备等产品将不断涌现, 满足不同应用场景的多样化需求。

CXL 在 2026 年迎来拐点

2026 年,CXL 将确立其在算力基础设施中的核心地位。其通过内存池化、缓存一致性、低延迟等特性, 有效解决了「内存墙」、资源孤岛和扩展性限制三大关键问题, 为高效 AI 模型提供了更优的算力成本和资源利用率。届时,CXL 将成为驱动 AI 算力基础设施变革的关键技术, 为数据中心、云计算、边缘计算等领域带来革命性变化。

五、 汽车:CXL 的下一个蓝海市场?

2025 年 5 月, 大众汽车旗下软件公司 CARIAD 发表文章《The Fast Lane of Data: Leveraging PCIe in Modern Vehicle Architectures》, 透露其计算平台将采用 PCIe Switch。更早之前, 高通第一代智能驾驶系统 Ride 3.0, 已率先在汽车行业使用 PCIe Switch(Microchip PM43028B1)。这一趋势引人深思:相比 PCIe Switch,CXL 未来将替代整个 PCIe Switch 市场。并且, 汽车领域对低延迟的要求极为严苛, 而这恰恰是 CXL 的核心优势之一。汽车电子架构的演进, 正为 CXL 开辟一个潜力巨大的新市场。

六、 结语

从芯片到整机, 从内存控制器到 Switch 芯片, 从单机箱资源池化到跨机架异构计算,CXL 的发展稳扎稳打。

随着 CXL 生态的不断完善, 其应用边界将不断拓展, 不再局限于服务器和 AI 领域, 而是逐步渗透到自动驾驶、边缘计算乃至整个 ICT 产业。它将成为连接「算力」与「效率」的关键桥梁, 成为推动行业深刻变革的「隐形推手」。

CXL 的产业化进程印证了新一代互联协议发展的客观规律:十年前 PCIe 通过标准化接口实现主板组件互联, 如今 CXL 正以相似的技术演进逻辑——在保持向下兼容性的前提下, 通过协议层创新突破现有架构瓶颈。它凭借一步一个脚印的积累, 规避了颠覆性变革带来的生态风险, 但同时它正重塑整个行业的底层逻辑。

来源:互联网