登顶全球开源代码模型王座

11 月 12 日,阿里云通义大模型团队开源通义千问代码模型全系列,共 6 款 Qwen2.5-Coder 模型。相关评测显示,6 款代码模型在同等尺寸下均取得了业界最佳效果,其中 32B 尺寸的旗舰代码模型在十余项基准评测中均取得开源最佳成绩,成为全球最强开源代码模型,同时,该代码模型还在代码生成等多项关键能力上超越闭源模型 GPT-4o。基于 Qwen2.5-Coder,AI 编程性能和效率均实现大幅提升,编程「小白」也可轻松生成网站、数据图表、简历、游戏等各类应用。

编程语言是高度逻辑化和结构化的,代码模型要求理解、生成和处理这些复杂的逻辑关系和结构,通常也被认为是大模型逻辑能力的基础来源之一,对于整体提升大模型推理能力至关重要。Qwen2.5-Coder 基于 Qwen2.5 基础大模型进行初始化,使用源代码、文本代码混合数据、合成数据等 5.5T tokens 的数据持续训练,实现了代码生成、代码推理、代码修复等核心任务性能的显著提升。

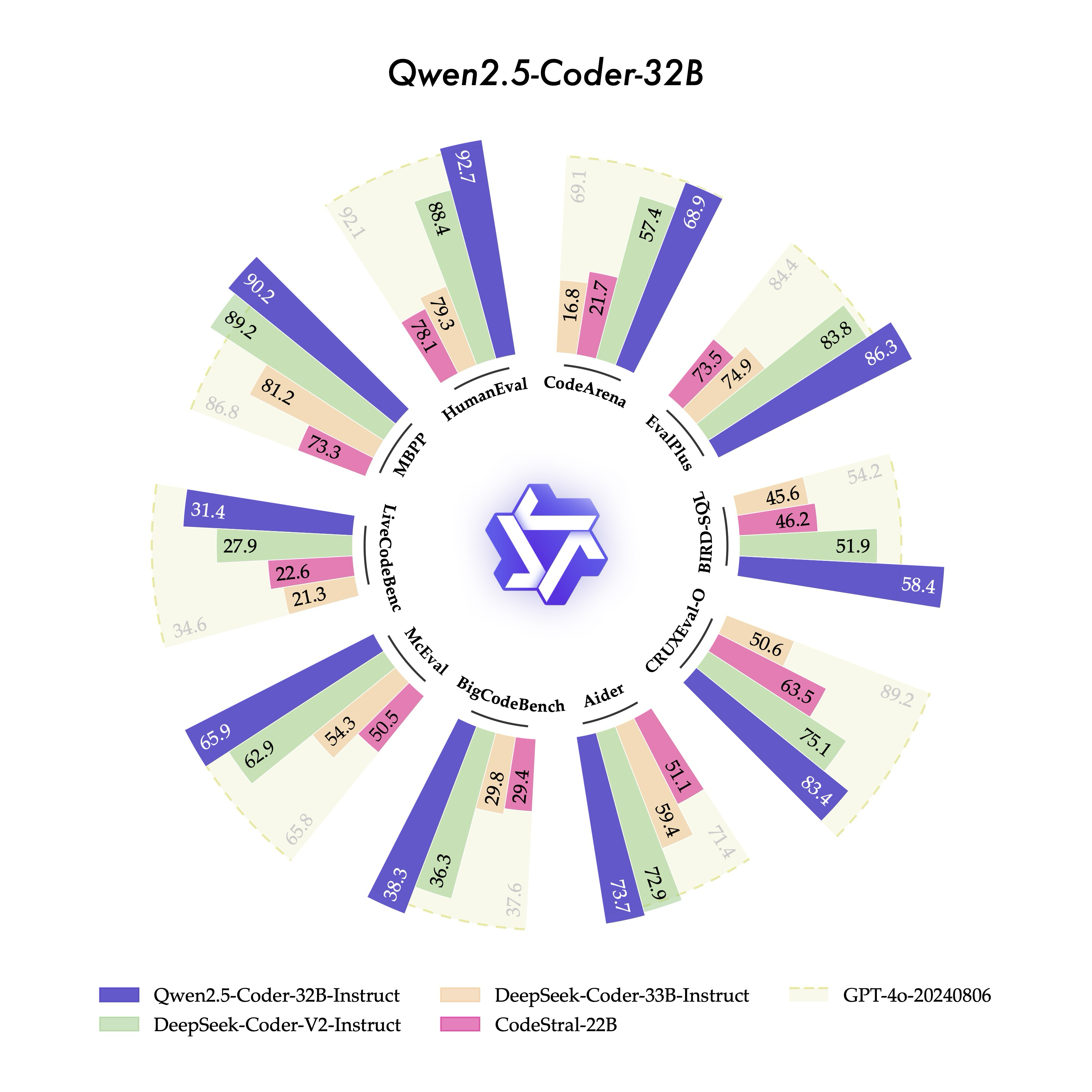

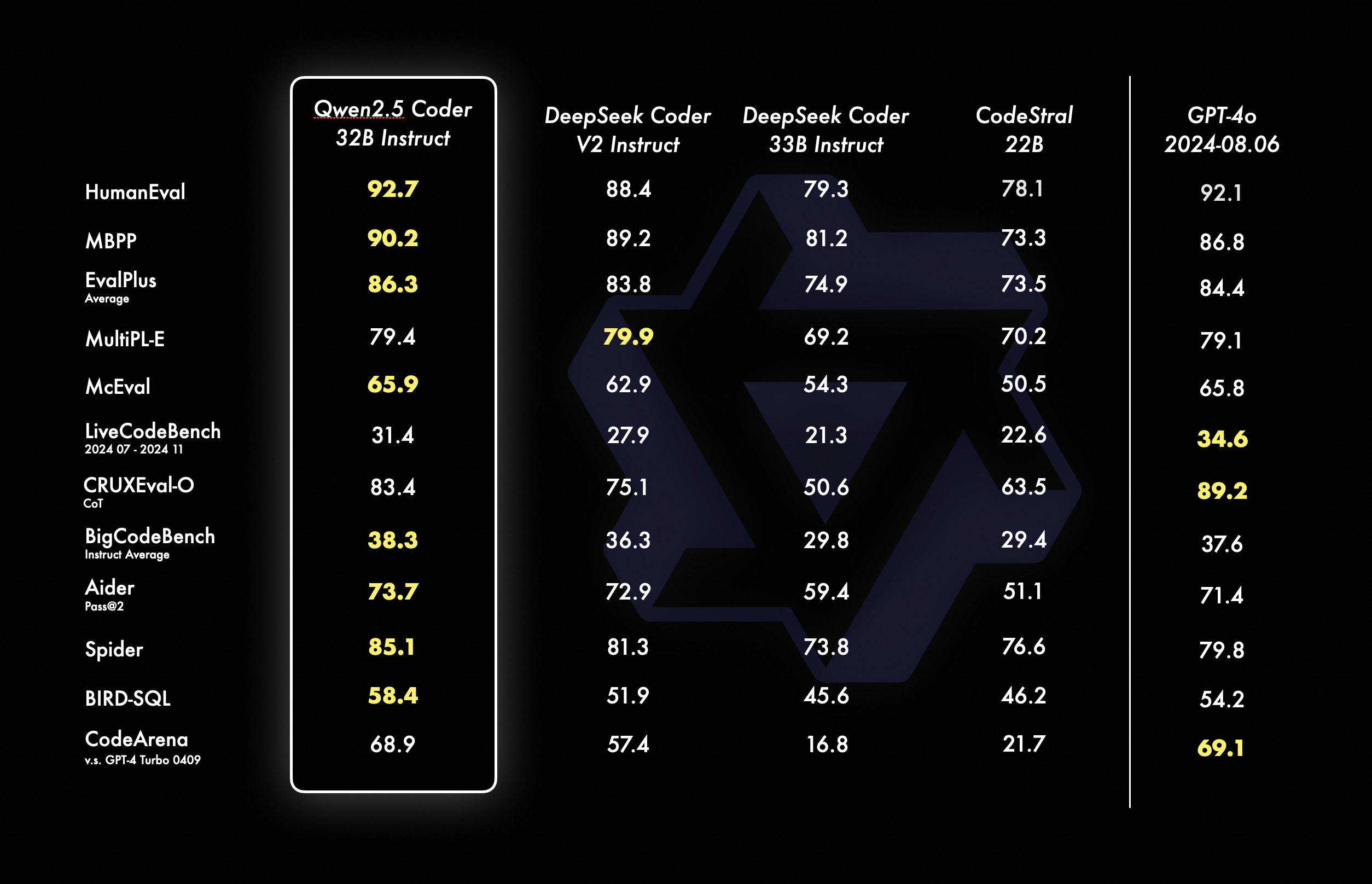

其中,本次新发布的旗舰模型 Qwen2.5-Coder-32B-Instruct,在 EvalPlus、LiveCodeBench、BigCodeBench 等十余个主流的代码生成基准上,均刷新了开源模型的得分纪录,并在考察代码修复能力的 Aider、多编程语言能力的 McEval 等 9 个基准上优于 GPT-4o,实现了开源模型对闭源模型的反超。

在代码推理方面,Qwen2.5-Coder-32B-Instruct 刷新了 CRUXEval-O 基准开源模型的最佳纪录。Qwen2.5-Coder-32B-Instruct 在 40 余种编程语言中表现优异,在 McEval 基准上取得了所有开闭源模型的最高分,并斩获考察多编程语言代码修复能力的 MdEval 基准的开源冠军。

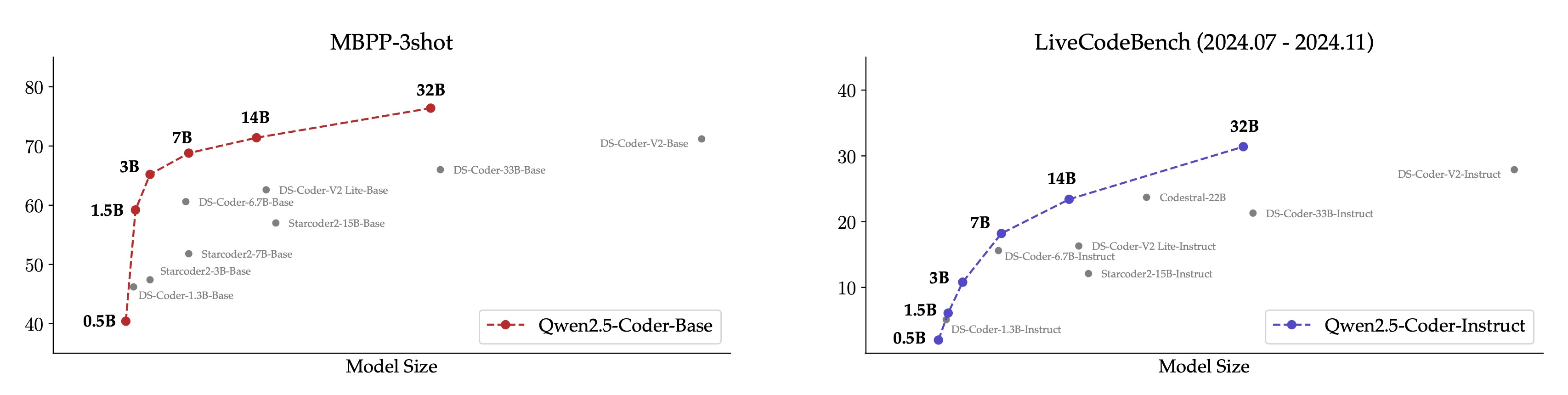

此次开源,Qwen2.5-Coder 推出 0.5B/1.5B/3B/7B/14B/32B 等 6 个尺寸的全系列模型,每个尺寸都开源了 Base 和 Instruct 模型,其中,Base 模型可供开发者微调,Instruct 模型则是开箱即用的官方对齐模型,所有 Qwen2.5-Coder 模型在同等尺寸下均取得了模型效果最佳(SOTA)表现。

Qwen2.5-Coder 全系列开源,可适配更多应用场景,无论在端侧还是云上,都可以让 AI 大模型更好地协助开发者完成编程开发,即便是编程「小白」,也可基于内置 Qwen2.5-Coder 的代码助手和可视化工具,用自然语言对话生成网站、数据图表、简历和游戏等各类应用。

截至目前,Qwen2.5 已开源 100 多个大语言模型、多模态模型、数学模型和代码模型,几乎所有模型都实现了同等尺寸下的最佳性能。据了解,全球基于 Qwen 系列二次开发的衍生模型数量 9 月底突破 7.43 万,超越 Llama 系列衍生模型的 7.28 万,通义千问已成为全球最大的生成式语言模型族群。