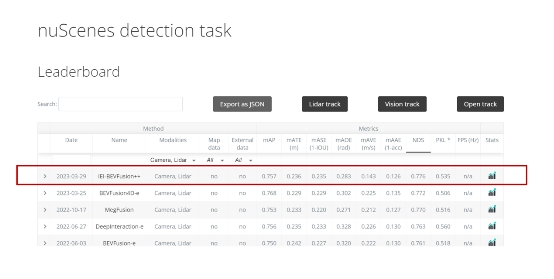

近日, 在全球权威的自动驾驶 nuScenes 竞赛最新评测中, 浪潮信息算法团队所提交的「IEI-BEVFusion++」算法模型在关键性指标nuScenes Detection Score(NDS) 得到 77.6% 的高分,创造了 3D 目标检测全赛道迄今最高成绩。

近日, 在全球权威的自动驾驶 nuScenes 竞赛最新评测中, 浪潮信息算法团队所提交的「IEI-BEVFusion++」算法模型在关键性指标nuScenes Detection Score(NDS) 得到 77.6% 的高分,创造了 3D 目标检测全赛道迄今最高成绩。继去年以「DABNet4D」登顶纯视觉 3D 目标检测榜单后, 该算法团队在面向融合感知自动驾驶领域再一次实现突破。

nuScenes 数据集是目前自动驾驶领域中最流行的公开数据集之一, 数据采集自波士顿和新加坡的实际自动驾驶场景, 是第一个集成摄像头、激光雷达和毫米波雷达等多种传感器, 实现 360 度全传感器覆盖的数据集。nuScenes 数据集提供了二维、三维物体标注、点云分割、高精地图等丰富的标注信息, 包含 1000 个场景, 拥有 140 万帧图像、39 万帧激光雷达点云数据、23 个物体类别、140 万个三维标注框, 其数据标注量比 KITTI 数据集高出 7 倍以上。

犹如人类的眼睛为大脑提供了 70% 以上的信息, 在自动驾驶领域, 作为感知系统的主流模式架构,Lidar 与 Camera 融合的 3D 多模态架构则为实现高鲁棒、高精度的 3D 目标检测提供了至关重要的信息输入, 为业内提供更具通识性的解决方案。此次创 nuScenes 榜单成绩新高的「IEI-BEVFusion++」算法模型正是应用了 3D 多模态融合架构的思路, 将 Lidar 与 Camera 形成有效的交互融合。

●Lidar 与 Camera 的多模态交互融合, 面临巨大挑战

3D 目标检测作为自动驾驶至关重要的核心任务, 面向强大的环境感知, 自动驾驶车辆通过广泛车载传感器的信息输入, 实现精准的目标检测。以 Lidar 为例, 它可以有效精准地捕捉空间信息, 点云数据所具备的天然 3D 优势, 最大程度地提升了检测目标的测距精度、速度及方向;而 Camera 的优势则在于, 它具备丰富的纹理信息, 强大的语义及图像上下文理解能力使得它可以有效地识别行人、交通指示牌等具象化的路面信息。因此,Lidar 与 Camera 融合的 3D 多模态架构将深度信息与纹理信息形成有效的交互融合, 为更精准的 3D 目标检测提供了一种全新思路。

然而, 将两种截然不同的模态几何和语义特征在一个表示空间内相结合, 这是一个巨大的挑战。一方面, 预估检测目标的深度信息是提升 3D 目标检测精度的关键, 现有模态的融合通常关注于点云雷达及 Camera 虚拟点间的交互, 但由于点云雷达远比 Camera 数据稀疏得多, 传统的融合方式无法解决固有模态间的深度信息差距。另一方面, 在跨模态的融合交互中, 点云雷达涉及体素的精细划分及大量的 3D 卷积计算, 图像则由于多摄像头、高分辨率, 复杂的特征提取网络, 两者计算复杂且耗时长。因此, 不同形态的数据整合也为多模态融合模型的训练速度和检测精度带来了新一层算力压力。

●NDS 77.6%,多模态融合模型「IEI-BEVFusion++」刷新全赛道记录

|

|

|

IEI-BEVFusion++多模态融合模型, 通过更有效的多模态训练架构、更精细的特征提取网络、更强大的数据预处理能力, 实现 Lidar 与 Camera 的高效特征提取与融合优化。激光雷达点云特征为 Camera 数据提供检测目标的精确 3D 信息,Camera 发挥其纹理轮廓及语义理解优势, 进一步精细化点云区域特征, 形成 Liar 与 Camera 的数据最大化互补, 大幅优化了模型的检测精度。

基于 Lidar 与 Camera 的多模态融合模型架构, 实现了三大核心技术突破:

-IEI-BEVFusion++多模态融合模型架构图-

a)首先, 基于更有效的多模态训练架构, 使得 mAP(全类平均正确率,mean Average Precision) 平均提升 2%+

Transformer 的多模态数据融合架构, 通过引入基于 Camera 数据的 BEV 检测头, 辅助融合模型训练, 在不增加过多计算量的同时, 进一步增强语义信息特征, 使得 mAP(全类平均正确率,mean Average Precision) 平均提升 2%+。

b)其次, 精细的特征提取网络, 大幅提升目标的 3D 检测能力

一方面, 采用多尺度 Lidar 的特征融合技术, 进一步增强其特征提取的感受野, 提升其对于检测目标, 尤其是大目标的表征能力;另一方面,Lidar 信息可直接辅助优化 Camera 的深度预测, 采取级联深度辅助策略, 大幅提升图像的 3D 检测能力。

c)同时, 强大的数据预处理能力, 实现模型精度与训练速度双突破

创新设计 Lidar 与 Camera 同步贴图, 替代了业内传统的 cbgs(类平衡分组和采样) 技术。一方面增强了样本的均衡性与多样性, 另一方面保证了不同模态间的数据协调、同步, 在提升目标定位检测精度的同时, 保障目标速度、方位、缩放等相关指标的提升, 训练速度更是较业内基准提升了 4.5 倍。

基于 BEV 融合算法的创新,「IEI-BEVFusion++」算法模型成功登顶 3D 目标检测任务 (nuScenes detection task) 全赛道榜单, 将关键性指标 NDS 提升至 77.6%。未来, 浪潮信息算法团队将践行多角度切入, 发挥算法、算力融合的全栈解决方案能力, 推动自动驾驶领域的技术创新发展。

备注:文内所涉术语解释如下

1)BEV:Bird』s Eye View, 是指将特征信息转化至鸟瞰视角

2) 多模态融合:也称多源信息融合或多传感器融合, 是指综合两个或多个模态的信息进行预测的过程

3) 鲁棒 (Robust):是指系统在一定的参数摄动下, 维持其它某些性能的特性

来源:互联网