AI 视觉的安全性依然值得重视。

不久前,某知名品牌汽车被曝其自动驾驶系统无法识别白色货车箱体这样类似于「一堵墙」的障碍物。在自动驾驶中,行人、车辆被漏检或者未能及时被检测到,都可能导致交通事故的产生。此外,安防漏检危险人物与物品也可能导致安全隐患。这些风险都提示,AI 视觉的安全性值得重视。

在研究 AI 视觉稳定性的过程中,阿里安全图灵实验室的研究人员札奇发现,AI 视觉还有一个盲区:利用算法自动鉴别图片关键信息,并巧妙删除,就像给图片「打码」一样,AI 视觉系统就会无法识别该图片。最近,这项研究成果被 AI 顶会 ICCV 2021 收录。

札奇的研究源于逛商场看到乐高玩具迸发的灵感。当时,她有一个疑问:「人眼如何识别『马赛克』式样的玩具?还有早期的超级马里奥,虽然只是由几个简单像素组成,人却可以正确识别这种抽象的表达。AI 模型面对『马赛克』式的图片,能正确识别吗?」

札奇进行了验证。她发现,传统对图片「加工」以骗过 AI 的方法是给图片加上「噪音」,相当于在当前图片上针对模型「乱涂乱画」,让 AI 无法识别,但原图片本身的关键信息没有丢失,只要用「橡皮擦」擦一擦,AI 依然能识别。如果反向操作,删除图片的关键信息,就像打「马赛克」,图片的关键信息已经丢失,那么 AI 无论如何也难以识别。这意味着,针对「打码攻击」,难以有防御措施。

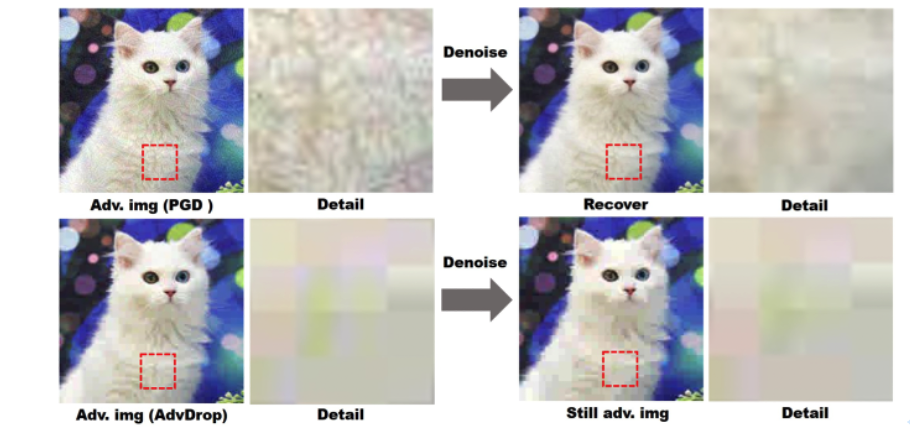

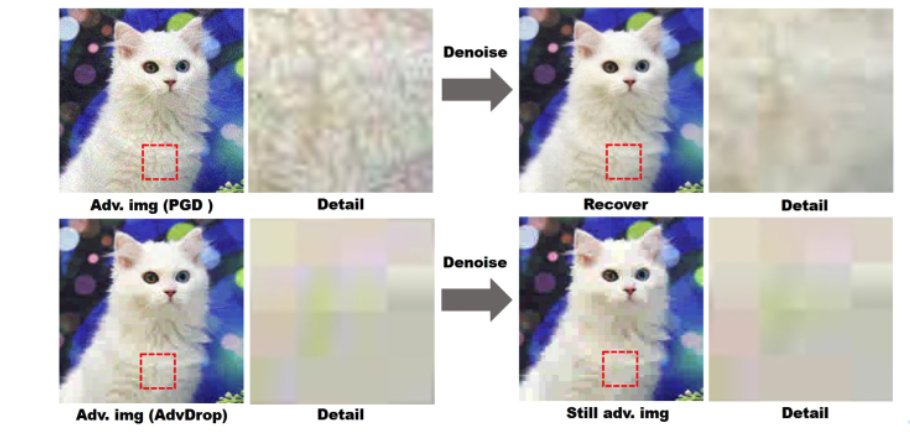

如下图所示,给猫咪图片加上噪声,去除噪声后,AI 模型依然能认出这是一只猫咪。相反,基于信息丢失的对抗攻击在去噪声的操作下基本没什么变化,AI 视觉模型「识别无能」。

专注对 AI 的对抗样本和模型安全性进行研究的阿里安全高级算法专家越丰提醒,除了 AI 视觉场景,真实场景中也可能存在这种对抗攻击,例如针对某知名 PS 软件,只要提供具备对抗攻击性质的 JPEG 量化表,就能产出有「攻击性」的图片。

此外,在实际场景中,图片信息丢失是常见现象,例如用户将图片以 JPEG 形式上传到网络,就有一定的信息丢失,可能不经意间就会制造一个「对抗样本」。越丰认为,这对当前内容安全场景的 AI 识别而言,都是不小的挑战。

「比如有人将涉黄赌毒图片以损失部分信息的形式上传到网络,人眼依然能领会含义,但 AI 却没能正确识别,这对构建清朗、健康网络环境而言,就是一种对抗。」越丰举例道,AI 安全行业应该警惕这种类型的对抗。

当然,「致盲 AI」不是研究人员的目标,研究人员最终还是想发现 AI 模型的脆弱性,进一步提升 AI 安全。「在 AI 安全前沿技术上进行探索,一是为了让 AI 更安全,二是为了让 AI 助力安全,三是为解决具体社会问题寻找提效的新途径。」阿里安全图灵实验室负责人薛晖提醒,相比「事后弥补」,安全应前置,从源头守卫安全,对前沿技术进行研究布局,以科技创新造就最好的网络安全。