当虚拟的内容在手机上以 AI 的方式呈现,并且得到了大众的认可,AR 迎来了真正两个大的爆发点、增长点的开始,一个是苹果推出 ARKit,一个是 Google 在前两个月推出的 ARCore。

增强现实是什么?

增强现实可以把它理解为一种叠加在用户眼前与真实世界之间,显示这种虚拟内容的一个技术,比如通过智能眼镜,但增强现实并不只有这一种形态,它还有很多包括我们可以透过手机屏幕去看的增强现实,像 ARKit 或 ARCore 这样的东西,也包括更加玄学(科幻)一点的全息投影这样的技术,其实都可以被叫做增强现实,而且说的再进一步,增强现实也不单单是视觉上的增强现实。

关于微软的 HoloLens,微软就曾经强调过一点,就是当你在讨论增强现实、混合现实,以及讨论你如何去和这个空间互动的时候,你所互动的不仅仅是视觉上的内容,还包括听觉上的,因为,微软谈到它怎样去创造立体声的效果,然后给人一个空间感,把人带入虚拟的空间或者说带入增强现实,所以说这是增强现实的一个概念,希望大家不要被网上已有的(就是说一定是在眼前叠加一块玻璃)这种想法所束缚住。

但究竟怎么让这些东西现实出来呢?目前的增强现实主要有几个技术:

第一、手机屏幕;

第二、头戴显示设备;

第三、全息投影。

我们给大家主要讲头戴式的设备,但也有很多其他形态:ODG、爱普生他们把自己的产品都做成了接近眼镜的形态;微软、Meta 则将产品做成了一种接近头盔的形态;而 Google glass 使用了单目显示,他们每一个都是很优秀的产品,但形态上存在很大的差异。甚至说,这个里面还看到了一个长的像 Cardboard 盒子一样的 holokit,大家可以用一个成本非常低廉的纸盒子,就体会到增强现实了。

当虚拟的内容在手机上以 AI 的方式呈现,并且得到了大众的认可,AR 迎来了真正两个大的爆发点、增长点的开始,一个是苹果推出 ARKit,一个是 Google 在前两个月推出的 ARCore。

新时代的曙光

如果熟悉这个行业的人应该知道,在过去的 1 年里面,有一些增强现实的智能眼镜公司或者做 SDK 的公司纷纷消亡了,在 2013 年、2014 年刚刚开始的时候,随着 Google glass、智能穿戴设备的出现,增强现实跟着风口往上稍稍走了一点,当整个投资、环境、市场、消费者全都冷静下来之后,C 端觉得这个东西好像没什么用,这时候面临了一个幻灭期,2015 年、2016 年,应该说企业就是这么熬过来的,但是在这个 2017 年的今天的这个节点上,一切可能会不太一样。

首先,我们来看一看这个,ARKit 和 ARCore,谷歌和苹果在今年的 6 月份和 8 月底的时候,纷纷发布了适用于自家智能手机系统的两个 AR SDK,这两个 ARSDK 的意义是什么呢?大家可以注意一下它们的数量。苹果的 ARKit 可以支持 3.8 亿台 iOS 设备,当然这个数字还是他刚刚发布的时候给出的一个数字,现在随着新的 iPhone 的发布,这个数字肯定会不断地攀升。ARCore 这边,谷歌虽然说在前期仅仅支持了个别的几个机会三型,但是大家也可以看到后续的工作,Google 也在积极的推广、进行。

ARKit 和 ARCore 的核心技术无非是三点:

1、运动跟踪。

2、环境理解。

3、光线预测。

这两家公司选了很有意思的方案,了解头戴设备的都知道设备上一般需要多个摄像头,而手机一般只有 1 个摄像头,虽然现在的双摄也是一个趋势,但是这些公司无一例外的选择了「单摄像头+陀螺仪」的方案,来做一个手机上的实时定位与空间的感知重建。这就极大降低了用户踏入到 AR 领域的门槛,加上他们背后分别代表了两大智能手机的操作系统,这两大智能手机操作系统最宝贵的就是他们的生态,借助这个生态,他们是可以把 AR 的内容给做起来的。

AR出了什么问题?

现在国内外做智能眼镜硬件的公司众多,包括像微软这样的大牌公司,他们推出了 HoloLens,严格意义上说,现在也是一个不温不火的状况。所以问题在哪里呢?

在电影《攻壳机动队》里面,大家可以看到增强现实的内容是怎么被展示的:AR 内容被放到一个摩天大楼一样的尺度上的,或者说满天可以飘着一些鲸鱼、机器人广告。我们 AR 行业的从业者在面对这些场景的时候,我们的想象力是不是没有长期从事内容制作的人丰富。所以说,希望这个对拓展你们的想象力有一些帮助,AR 现在需要有吸引力的内容来引领它的爆发。

缺失的一环

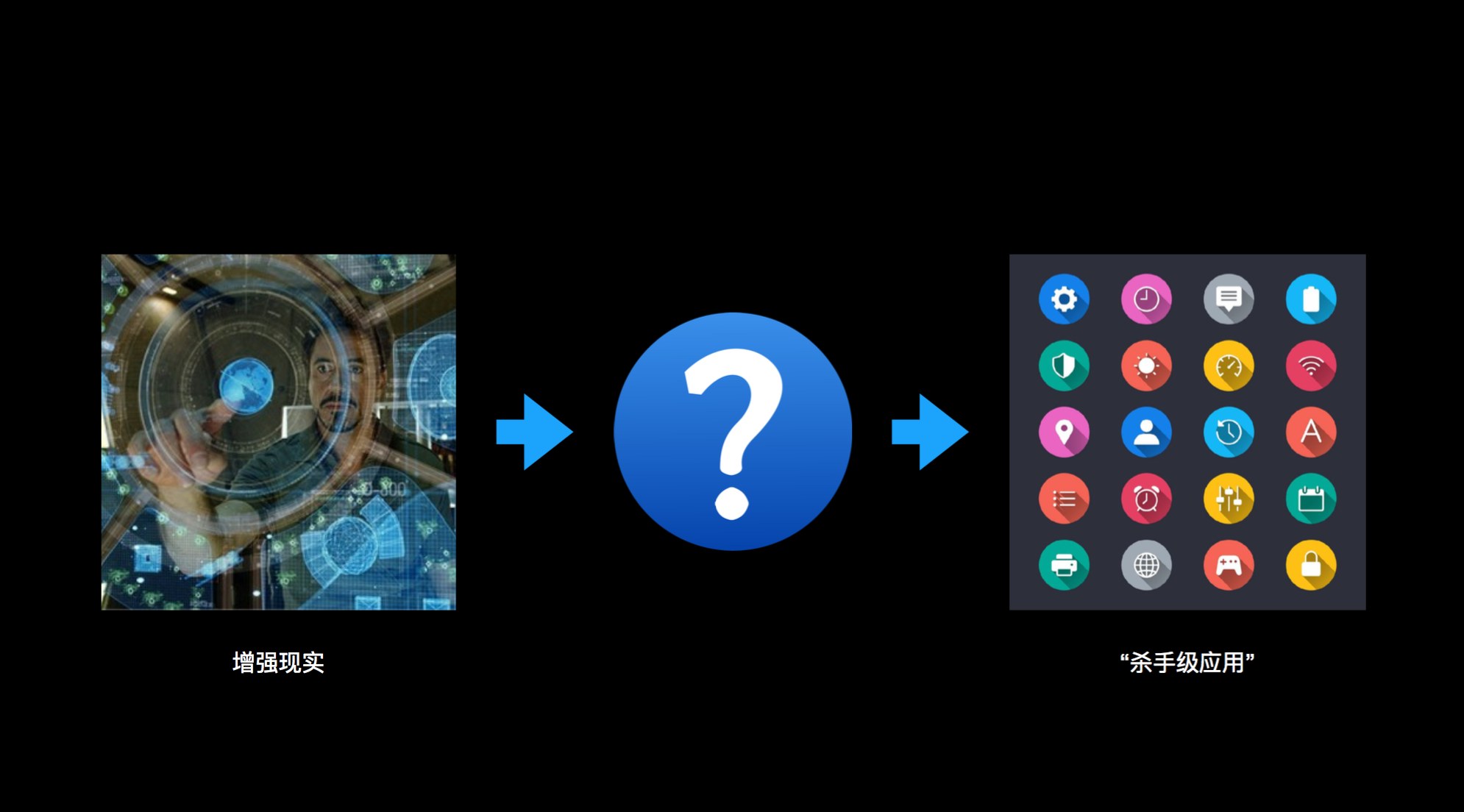

很多人都把 AR 的爆发和流行归结为我们需要有杀手级应用,我觉得这是一个不对的推导逻辑,中间我们缺失了一环。增强现实这个东西,我们大家应该把它当做一个更基础的技术来看待,因为增强现实意味着新的生态和新的规则。AR 既然它是一个很基础的平台,那么要连接很顶层的应用,他们之间缺了一个什么环节呢?这个缺失的部分,其实很难形象的跟大家去解释,它有一点类似于今天的应用商店,就是说,我们缺了一个能够让用户去获取、创造、发布自己应用的平台。

手机的瓶颈

最近三年,智能手机的出货量几乎处于一个没有增长的状态,始终在这个数量级上进行一个小范围的波动,另外,更重要的一点,从 2013 年开始的 4 年,消费者更换手机的频率增长了 9 个月,这是英国的一个统计数据,而且更加致命的是,51% 的消费者在最近的一个月里,没有下载过一个新的应用,这背后的问题有很多,我们可以捡其中比较重要的一些因素来讲,手机更新的频率,无非就是现在的手机,我不管是用 6 还是用 8,甚至用 X,其实它都没有什么本质的区别,今年发布的 iPhone 8 不是被大家叫 6SSS 嘛,这个是一个很严峻的问题。

另外就是有一半的消费者,在最近的一个月里,没有下载过新的应用。我们已经倾向于从自己已有的应用里面去获取,就是说,AR 时代,应用的获取将会变的更加隐蔽,因为这是用的一个诉求,是提升用户体验的一个重要环节。

智能眼镜

智能眼镜是一个应该说被 C 端的,或者说被普遍的消费者看来是一个比较新奇的玩艺,最近几年才走入大家的视野,我们希望借此来让我们人的感知达到一个新的维度的延伸。

如下是智能眼镜和手机的比较。

智能眼镜的交互设计是什么样的?

AR 内容虽然会从手机上爆发,但是我认为也就是手机接触屏幕到相机,去扫一下,和 AR 内容互动,也就到这为止了,下一步开始,一定是从智能眼镜再往下走的。不过我们不管是设计 AR 内容,还是去做增强现实的硬件,我们要始终牢记的一点,就是产品是交给用户用的。

舒适性和易用性

大家可以看到,绿色的区域一般来说就是拇指可以操作的热区,或者说食指可以操作的热区,橙色区域就不太好点了,红色区域是几乎点不到的。上面这个图的标准就是当我手指用不同的姿势去点击的时候,按纽设计成多大比较合适,当然,这个都是今天的标准我们不应该再以这个为标准了,智能眼镜在这个设备上,我不知道有没有人玩过 Google glass 或者其他的智能眼镜产品,有很多产品尝试着把手机上,或者说鼠标上的人机交互方式给搬到智能眼镜屏幕上,其实这个是错的,我们先要从这开始理解。

人体测量学数据

这个图表上清晰的标注了人眼认知的范围,包括我们人眼可以观察到视野左右一共 188 度空间内的所有内容,但是我们只能够在水平视角 1-3 度的范围内,经过一个精确的阅读和理解。第二张图的时候,你会发现我们人对于颜色的理解也不是在所有视野里面对所有颜色都是敏感的。另外包括人头如何去转动,包括人的躯体如何去转动,过去我们在使用智能手机的时候,不会遇到的问题,在这里面都需要考虑到。

视觉辐辏调节冲突

另一个问题,这是一个在 VR 产品里面经常被提到的视觉辐辏调节冲突,这个是指的说,大家可以看到这张图上,这两个是我的眼球,当我的两只眼睛的眼球,通过视差的方法来判断这一个物体的距离的时候,如果这个物体,所在的距离与屏幕所呈现出来的虚拟距离是一致的,那这个时候,人们会认知它是正确的,如果说,我视差看到的这个影像处于这个距离上,但实际我屏幕显示光学技术导致的限制,让我看到的成像距离是近于它,或者是远于它的,这个时候,人就会有一种眩晕感。

空间影射与认知

我们现在是头戴式的 AR 显示设备,去和空间的内容进行一个互动,我们再也不是在手机屏幕上,去模拟过去一个白纸上去和文字互动的一个交互。我们这个时候看到的信息它是有深度的,它可能位于空间的任何一个位置。

合理的界面方案

Google glass 界面很有意思,它借用了一堆像卡片式的设计,大家可以想象,今天我们所看到的这个大屏幕就是一个卡片,当我在侧面的触摸板上不停的左右前后滑动的时候,眼前的卡片会一个接一个的切换,这个是 Google 在 2013 年的时候,对于 AR 设备界面的一个理解,但是随着时间的推移,包括越来越多的厂商加入,大家逐渐在头戴显示设备上找到了正确的界面方案,WIMP。

AR交互的核心-摄像头

摄像头现在在 AR 领域有几种方案,和手机上常用的不同,AR 领域现在用的第一个结构大家可能比较熟悉,因为 iPhone X 随着它的发布,大家都知道,我可以投出一堆不可见光的光点在人的脸上,或者在物体上,然后对深度的信息进行一个判断,由此来识别出这个人脸或者这个物体,结构光一般来说,就是这样的一个原理,它可能收的干扰会比较严重一些。还有一个叫飞行时间,飞行时间要求的技术就是要有这种飞秒级的快门,来计算光在空间中飞行的时间,无非就是光线打到你的人脸上,然后再进入到飞秒级快门时它一共花了多少时间,通过这个来算出距离。

另外一个就是多角度摄像头,这个大家应该不陌生了,我们使用多个布置在不同角度的摄像头来捕捉环境、捕捉人的手,或者是人脸,再或者是其他的物品,来计算出他们的深度,这个时候,就能做一些更复杂的交互了。

更聪明的摄像头

另外一个趋势就是说,摄像头会变的更聪明,这个变的更聪明我们可以从很多的角度去理解,因为它从面体现在很多方面,包括我们第一个场景里面所提到的,我把手机放到墙壁上,可以做一个图像识别,甚至直接做一个内容的翻译,然后再到前段时间,发布会发布之后火的不行的华为 mate10,它在自己的手机相机里面提出了更加智能化的一些功能,包括对于不同场景的分析,当我举起手机,对着大海、蓝天、拍一张照片的时候,手机会知道这是一张大海和蓝天的照片,它在取景的时候,就会自动根据这个场景,对曝光进行一个优化,当然,现阶段这个主要还是体现拍摄方面,或者说,翻译方面,很少在其他的方面有应用。

随着(物体识别、手势识别、人脸识别、图像识别)的不断进步我们相信相机对于场景、对于物体,对于人手智能的分析方面,会变的越来越强大。

更多的视角

摄像头在智能的头戴显示设备上,经常被大家所看到的一个视角无非就是接近人第一视角,向外去拍摄,而大家却往往忽略了朝里面放置的这颗摄像头,刚才我们在讨论交互的时候,我们曾经提到界面方案,是 WIMP,point 其实不光可视你的人头,或者是视你的人手,它也可以是视你的眼睛。

比如说像第一个,我们可以在镜框的内测布置一个小的眼洞检测装备,通过这个装备它可以判断到用户的眼球是如何移动的,然后通过眼球做一些简单的、不太耗费精力的指向性操作,或者说,还有可穿戴式相机,像 Google 这次发的clips,clips 这次作为一个可以灵活部署、可以放到任何位置的这种小相机模块,如果大家想象一下,我们在家里放置了 10 几个 20 个这样的相机,那将来他们可以怎样去感知我们周围的空间?

它所感知的空间,所传回来的数据,对我们做 AR 的交互,又能够有多大的有益的帮助。

另外这个大家就比较熟悉了,就是全景相机,全景相机这方面主要是在创造 AR 内容方面会有一些帮助,通过它来拍摄一些现场的,比如说我们现在在 798 里面玩一圈,然后把 798 里面的内容都给拍摄下来,把虚拟的内容,交给用户的 AR 投显去显示,或者说在手机屏幕上去显示。这样对方就能有一个虚拟的逛 798 的感觉了。